信息整理:图书馆

2024年诺贝尔物理学奖被授予美国普林斯顿大学科学家约翰·霍普菲尔德(John J. Hopfield)和加拿大多伦多大学科学家杰弗里·辛顿(Geoffrey E. Hinton),以表彰他们“基于人工神经网络实现机器学习的基础性发现和发明”。以下对两位诺奖得主的相关主题学术论文和施引文献进行分析。

一、获奖者发文分析

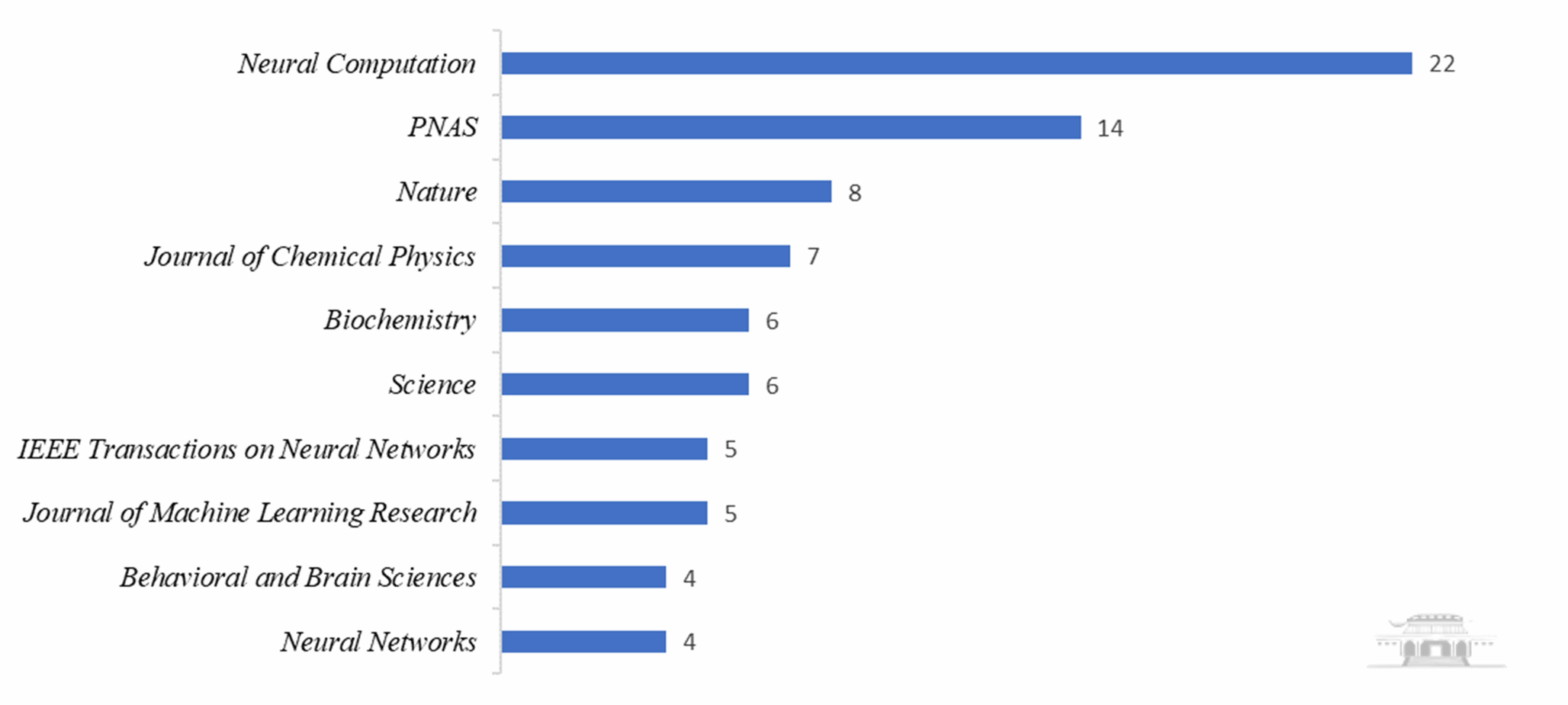

1979年至今,两位获奖者在神经网络及相关领域发表SCIE论文148篇(文献类型限制为“论文”或“综述论文”),主要涉及人工智能、神经科学、化学物理学等领域。论文分布于67种期刊,人工智能领域期刊Neural Computation发文量居第一,其次依次为PNAS(美国科学院院刊)和Nature,发文量TOP10期刊详见图1。

图1 2024年诺贝尔物理学奖获奖者相关SCIE论文期刊分布(TOP10)

单篇论文被引超过10000次有8篇,其中7篇为辛顿所著,1篇为霍普菲尔德所著;单篇最高被引达7万余次。按照发表时间升序排列,依次为:

1.霍普菲尔德1982年发表在PNAS上的论文“Neural networks and physical systems with emergent collective computational abilities”,被引11250次。受伊辛模型的启发,霍普菲尔德在本文中提出了一种基于能量函数的网络模型,被称为Hopfield网络。伊辛模型是统计物理中最重要的模型之一。

2.辛顿1986年发表在Nature上的论文“Learning representations by back-propagating errors”,被引17588次。这篇论文详细描述了反向传播算法(Back-propagation),使得训练多层神经网络成为可能。

3.辛顿2006年发表在Neural Computation上的论文“A fast learning algorithm for deep belief nets”,被引10294次。本文提出了深度信念网络(Deep Belief Networks, DBN)以及一种基于逐层无监督预训练的高效学习算法,让深层神经网络的训练变得可行,为现代深度学习的发展奠定了基础。

4.辛顿2006年发表在Science上的论文“Reducing the dimensionality of data with neural networks”,被引13022次。本文提出了一种利用深层自编码器(Autoencoder)实现数据降维的方法。通过无监督的逐层训练策略,自编码器能够学习到数据的复杂结构,这一突破推动了神经网络在特征提取和表示学习中的广泛应用。

5.辛顿2008年发表在JMLR(Journal of Machine Learning Research)上的论文“Visualizing data using t-SNE”,被引27706次。本文介绍了一种名为t-SNE(t-distributed Stochastic Neighbor Embedding)的降维算法,专门用于将高维数据映射到二维或三维空间,以便于可视化。t-SNE被广泛应用于图像数据、文本数据和基因组数据等高维数据集的可视化分析。

6.辛顿2014年发表在JMLR上的论文“Dropout: A simple way to prevent neural networks from overfitting”,被引25524次。本文提出的Dropout技术是一种简便、有效的防止神经网络过拟合的方法。通过随机关闭节点,Dropout强化了模型的泛化能力,并成为深度学习模型训练中的标准正则化工具。

7.辛顿2015年发表在Nature上的综述论文“DeepLearning”,被引24603次。本文的三位作者都是深度学习领域的奠基者,因此这篇文章被认为是深度学习领域的权威综述之一。文章全面总结了深度学习的基本原理、关键技术以及应用前景,是理解深度学习发展脉络的经典文献。

8.辛顿2017年发表在Communications of the ACM上的论文“ImageNet classification with deep convolutional neural networks”,被引70636次。本文最初于2012年在NIPS(现称为NeurIPS)会议上正式发表,后来为了便于更广泛传播和引用又被重新收录到期刊中。作者在这篇文章中展示了他们设计的深度卷积神经网络(CNN),即著名的AlexNet,在ImageNet大规模视觉识别挑战赛(ILSVRC)中取得了前所未有的分类精度。这一工作不仅刷新了图像识别的性能记录,也推动了深度学习在计算机视觉领域的应用和普及。

二、施引文献分析

截至2024年11月20日,两位获奖者的148篇论文在Web of Science核心合集中被全球201209篇文献引用,总被引245536次,篇均被引1659次。受数据库采购范围限制,可供分析的施引文献数量为197818篇。

1、发文年份对比

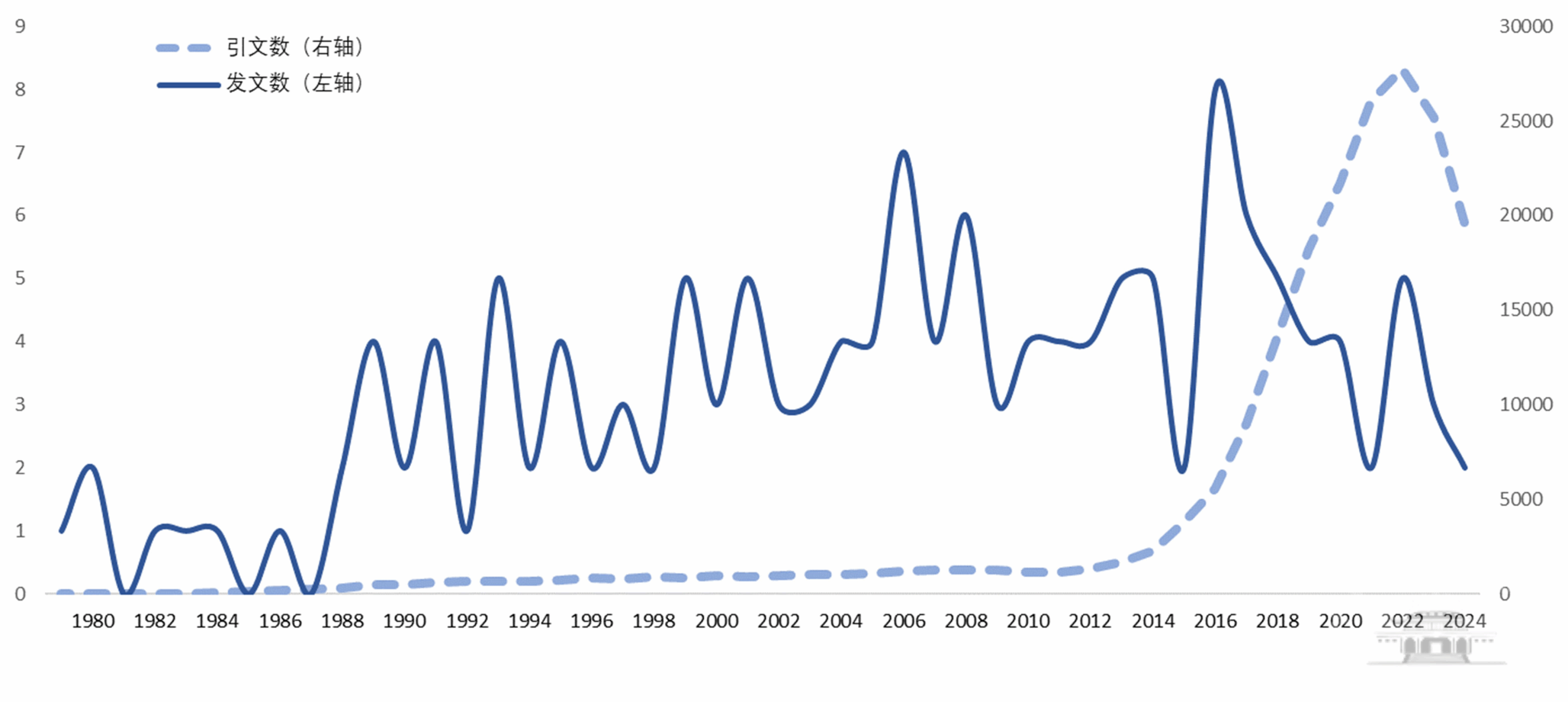

神经网络作为如今人工智能的主流技术流派之一,其发展也并非一帆风顺,获奖者的研究曾一度陷入低谷、关注者寥寥。对比获奖者的发文和施引文献的出版年份:获奖者发文中有141篇在2015年之前发表,占95%。而施引文献的数量在2010年之前增长缓慢,2012年开始增速有所提升,2015年开始快速增长,至2022年时达到最高点27758篇,随后略有下降。2015年及以后发表的施引文献数量为170616篇,占施引文献总数的86%。

图2 2024年诺贝尔物理学获奖者发文及施引文献的年份分布

2、学科领域对比

深度学习最初是受生物神经网络的启发建立起来的,例如人工神经网络(ANN)模拟了神经元的连接模式;而现代深度学习的发展已逐渐从模拟生物神经网络的初衷,转向以数据驱动和实际技术需求为主导。按WoS宏观主题划分,获奖者发文中论文数量前三的领域分别是:计算机科学人工智能(50篇)、神经科学(42篇)、多学科科学(30篇);施引文献数量前三的领域分别是:计算机科学人工智能(60684篇)、电子电气工程(52551篇)、计算机科学信息系统(28195篇)。施引文献相比于获奖者发文,工程领域的文献数量比重显著提高,而神经科学领域的文献数量比重显著下降。

3、ESI高被引论文

施引文献中ESI高被引论文共计3509篇。按WoS中观主题划分,计算机视觉和图形领域的论文数量为869篇,排名第一;其次为摩擦与振动领域,论文数量215篇;遥感领域的论文数量为204篇,排名第三。

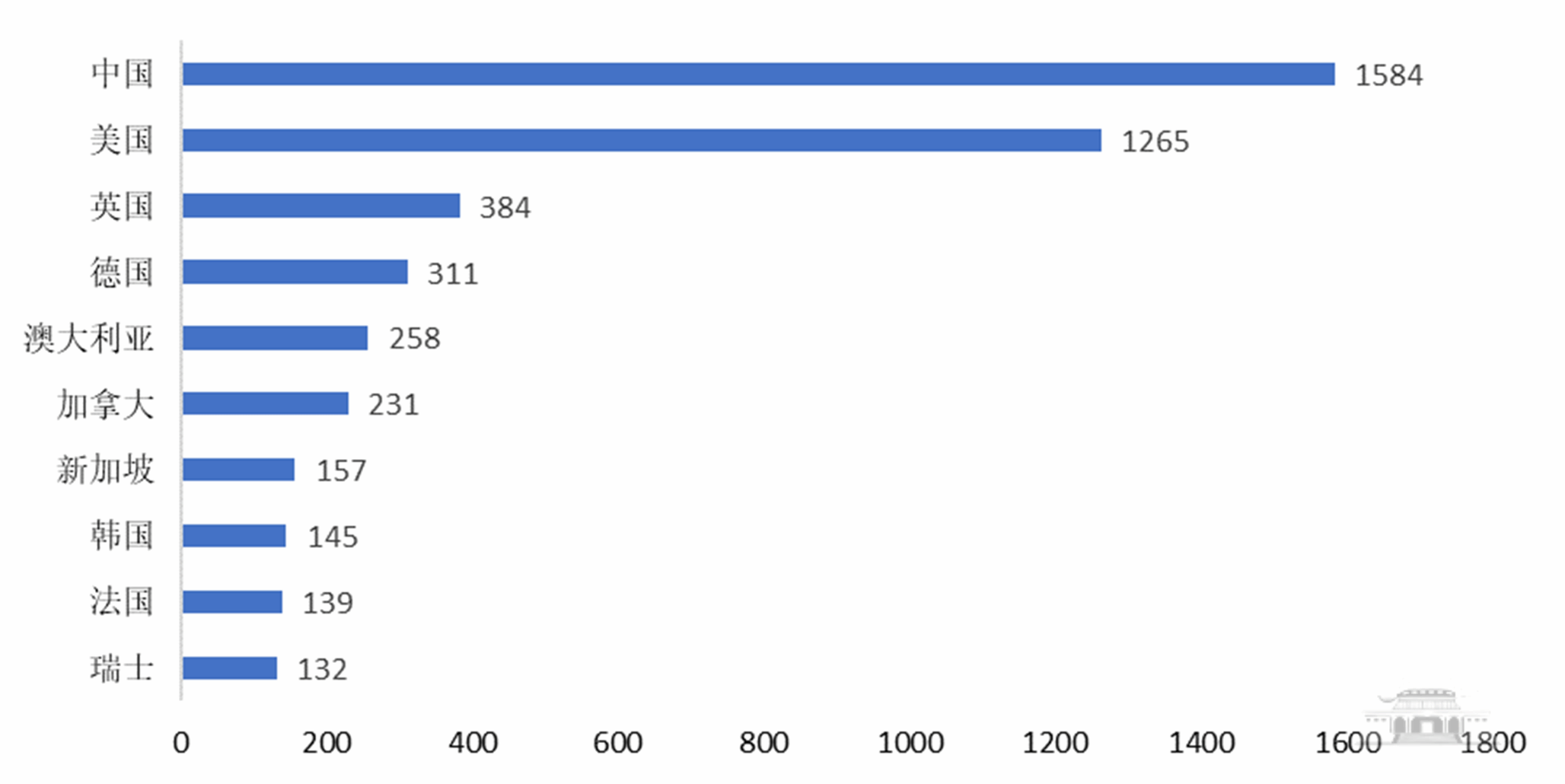

中国作者参与的1584篇ESI高被引论文引用了两位诺贝尔奖获得者相关成果,在所有国家/地区中居首位,其次为美国和英国。前十的国家/地区见图3。

全球施引文献发文机构中,ESI高被引论文发文量最多是中国科学院,其次是加利福尼亚大学和哈佛大学;另有两所中国机构发文量进入全球前十:清华大学居全球第七、武汉大学居全球第八。

图3 2024年诺贝尔物理学相关施引文献中ESI高被引论文发文量TOP 10的国家/地区

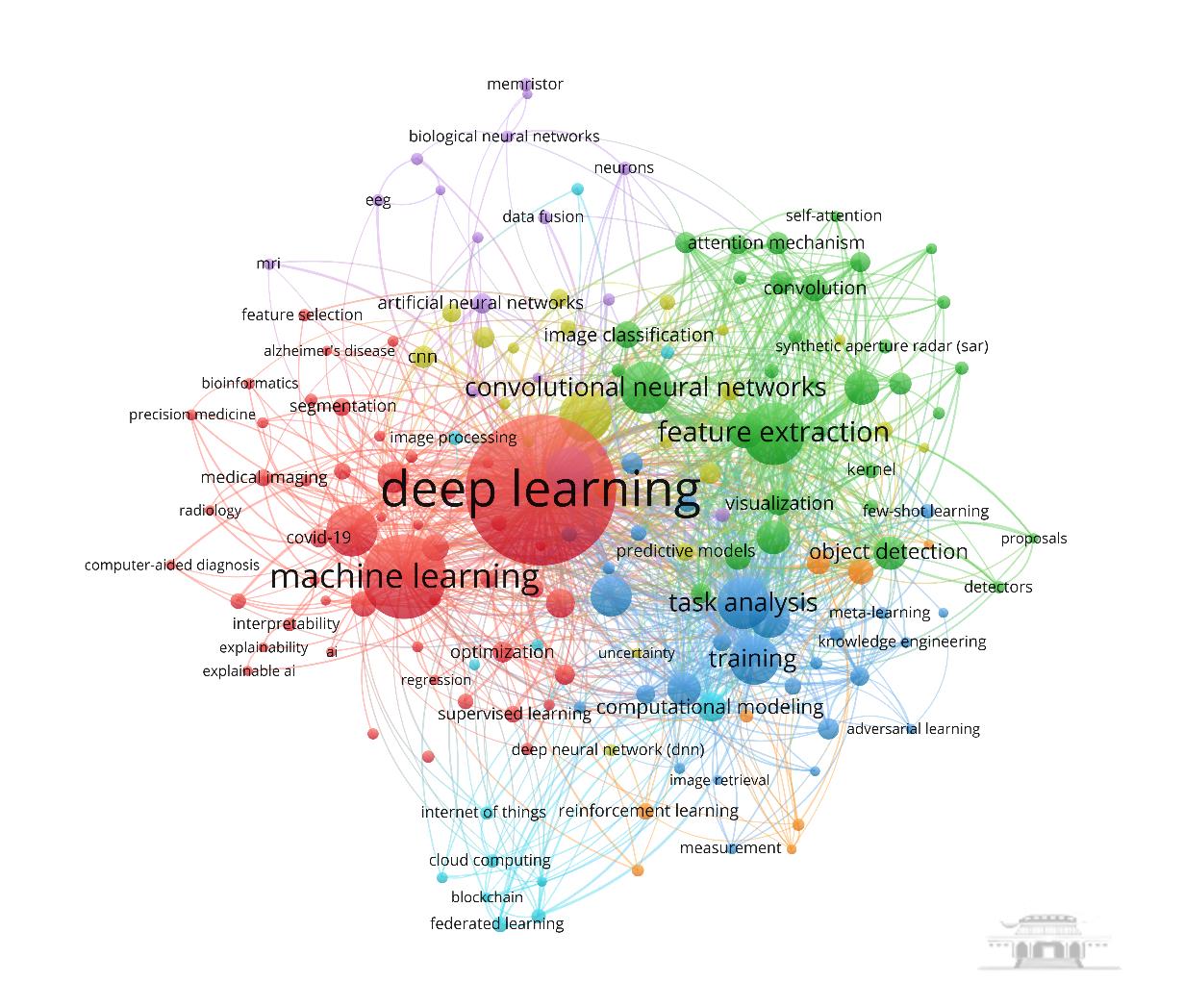

使用VOSviewer对施引文献中ESI高被引论文的作者关键词进行词频统计和聚类分析,可得如图4所示网络图。图中字号越大的关键词出现频率越高,相近颜色的关键词属于同一个聚类。出现频率最高的关键词是深度学习(deeplearning,出现1047次),其次是机器学习(machinelearning,出现387次)和特征提取(featureextraction,出现224次)。

图4 2024年诺贝尔物理学相关施引文献中ESI高被引论文关键词共现网络

三、相关主题高影响力施引论文

2023年至今,物理诺奖获得者论文的施引文献中,中国学者参与的人工智能领域热点论文共19篇,具体如下:

1. Qian Q, Luo J, Qin Y.Adaptive intermediate class-wise distribution alignment: A universal domain adaptation and generalization method for machine fault diagnosis[J/OL]. IEEE Transactions on Neural Networks and Learning Systems, 2024, 15(2024-03-21)[2024-12-01].https://doi.org/10.1109/tnnls.2024.3376449.

2. Liu Y, Zhang Y, Wang Y X, et al.A survey of visual transformers[J]. IEEE Transactions on Neural Networks and Learning Systems, 2024, 35(6): 7478-7498.

3.Li H L, Li J, Wei H B, et al.Slim-neck by gsconv: A lightweight-design for real-time detector architectures[J/OL]. Journal of Real-Time Image Processing, 2024, 13(2024-03-29)[2024-12-01]. https://doi.org/10.1007/s11554-024-01436-6.

4. Lau K W, Po L M, Rehman Y A U.Large separable kernel attention: Rethinking the large kernel attention design in cnn[J/OL]. Expert Systems with Applications, 2024,15(2023-09-01) [2024-12-01]. https://doi.org/10.1016/j.eswa.2023.121352.

5. Kong X X, Yu F, Yao W, et al.Memristor-induced hyperchaos, multiscroll and extreme multistability in fractional-order hnn: Image encryption and fpga implementation[J]. Neural Networks, 2024, 171: 85-103.

6. Ju W, Fang Z, Gu Y Y, et al.A comprehensive survey on deep graph representation learning[J/OL]. Neural Networks, 2024, 50(2024-02-27) [2024-12-01]. https://doi.org/10.1016/j.neunet.2024.106207.

7. Hassija V, Chamola V, Mahapatra A, et al.Interpreting black-box models: A review on explainable artificial intelligence[J]. Cognitive Computation, 2024, 16(1): 45-74.

8. Chang Y P, Wang X, Wang J D, et al.A survey on evaluation of large language models[J/OL]. ACM Transactions on Intelligent Systems and Technology, 2024, 45(2024-03-29) [2024-12-01]. https://doi.org/10.1145/3641289.

9. Cao H Q, Tan C, Gao Z Y, et al.A survey on generative diffusion models[J]. IEEE Transactions on Knowledge and Data Engineering, 2024, 36(7): 2814-2830.

10. Zhou K Y, Liu Z W, Qiao Y, et al.Domain generalization: A survey[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(4): 4396-4415.

11. Yang X L, Song Z X, King I, et al.A survey on deep semi-supervised learning[J]. IEEE Transactions on Knowledge and Data Engineering, 2023, 35(9): 8934-8954.

12. Wang Y B, Wu H X, Zhang J J, et al.Predrnn: A recurrent neural network for spatiotemporal predictive learning[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(2): 2208-2225.

13. Su H, Zhao D, Heidari A A, et al.Rime: A physics-based optimization[J]. Neurocomputing, 2023, 532: 183-214.

14. Liu X, Zhang F J, Hou Z Y, et al.Self-supervised learning: Generative or contrastive[J]. IEEE Transactions on Knowledge and Data Engineering, 2023, 35(1): 857-876.

15. Li Y H, Yao T, Pan Y W, et al.Contextual transformer networks for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(2): 1489-1500.

16. Li X X, Yang X C, Ma Z Y, et al.Deep metric learning for few-shot image classification: A review of recent developments[J/OL]. Pattern Recognition, 2023, 15(2023-02-02) [2024-12-01]. https://doi.org/10.1016/j.patcog.2023.109381.

17. Li K C, Wang Y L, Zhang J H, et al.Uniformer: Unifying convolution and self-attention for visual recognition[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(10): 12581-12600.

18. Han K, Wang Y H, Chen H T, et al.A survey on vision transformer[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(1): 87-110.

19. Cheng G, Yuan X, Yao X W, et al.Towards large-scale small object detection: Survey and benchmarks[J]. IEEE Transactions on Pattern Analysis and Machine Intelligence, 2023, 45(11): 13467-13488.

纰误之处,敬请批评指正!同时,也面向全校师生征集关注的领域和专题。联系方式:68779263,Email:kyzh@whu.edu.cn。

(编辑:张开阳、江珊 审核:刘颖、盛芳)