新闻网讯(通讯员网轩)近日,国家网络安全学院王骞教授和王鹃教授课题组两项最新成果被计算机视觉领域顶级会议—国际计算机视觉与模式识别会议(IEEE/CVF Conference on Computer Vision and Pattern Recognition, CVPR 2024)录用。

第一项研究工作由国家网络安全学院2022级硕士生岳新立完成,论文题目为“Revisiting Adversarial Training under Long-Tailed Distributions”(《重新审视长尾分布下的对抗训练》),指导老师为王骞、赵令辰副教授(通讯作者)。国家网络安全学院2021级博士生牟宁平参与了该成果的研究工作。

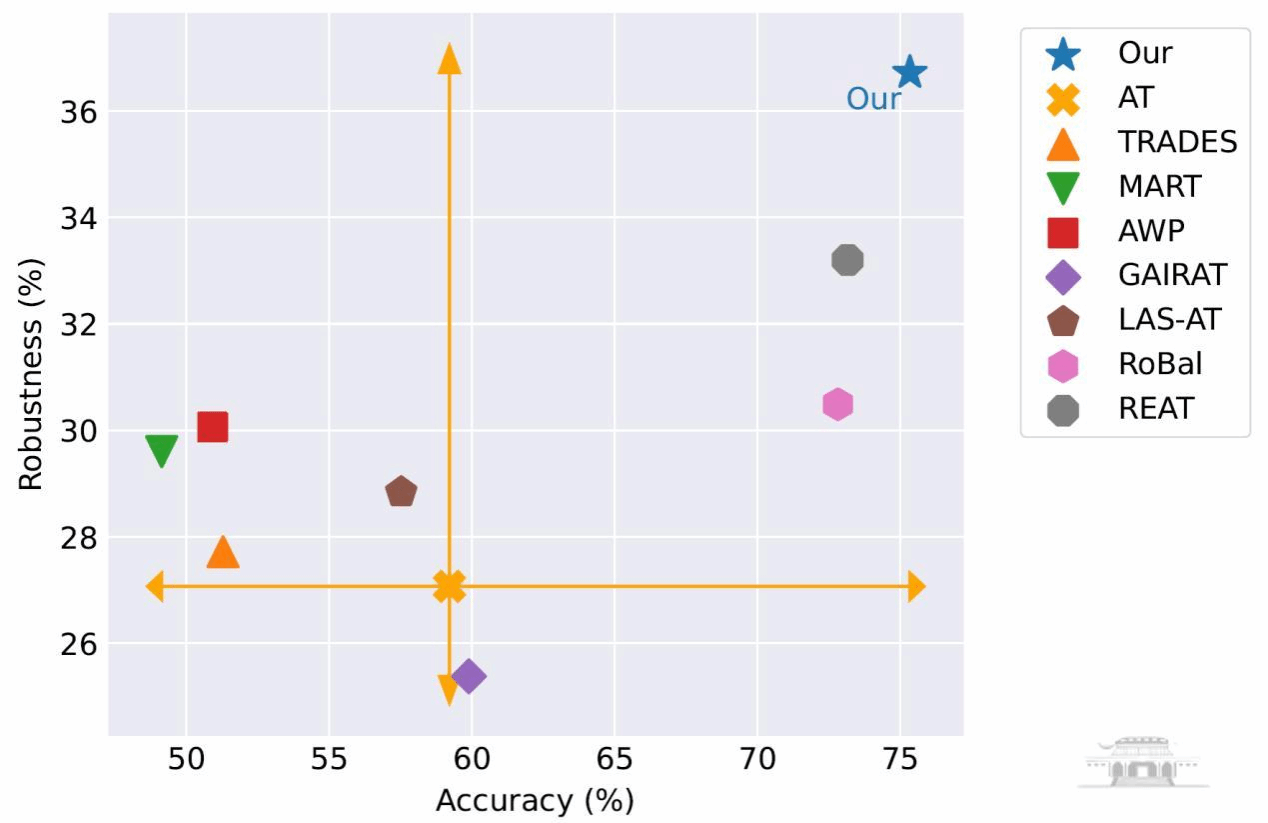

不同对抗训练方法在AutoAttack攻击下干净样本的识别准确率和对抗鲁棒性

深度神经网络容易受到对抗攻击的影响,导致输出结果错误。对抗训练目前被认为是抵抗此类攻击最有效的方法之一。现有的对抗训练技术大多在平衡数据集上进行测试,然而现实世界的数据往往呈现长尾分布,使得这些技术在现实场景中的有效性受到质疑。因此,作者深入研究了长尾分布下的对抗训练。在分析此前关于长尾分布对抗训练的工作“RoBal”(CVPR’21)后,作者发现仅使用平衡Softmax损失的方法就可以使模型达到与完整的RoBal方法相当的性能,同时也能够显著减少训练开销。此外,作者揭示了长尾分布下的对抗训练也存在和均匀分布类似的鲁棒过拟合问题,并且发现使用数据增强技术不仅能够有效缓解这一问题,同时还能提高模型的对抗鲁棒性。作者进一步探究了这一现象的成因是样本多样性增加,使得模型能够学习到更复杂和丰富的数据表征。在不同的数据增强策略、模型架构和数据集上的实验也证实了仅使用数据增强技术就能显著提高模型鲁棒性。

第二项研究工作由国家网络安全学院2023级博士生徐枭洋完成,论文题目为“A Stealthy Wrongdoer: Feature-Oriented Reconstruction Attack against Split Learning”(《一个隐蔽的攻击者:拆分学习中基于特征的数据重构攻击》)。该工作在王鹃(通讯作者)指导下完成,杨梦达,易文哲,李子昂,庄泳博士和刘雅欣硕士参与了本工作。

拆分学习场景下基于特征的数据重构攻击方法

数据重构攻击(Data Reconstruction Attack)是一种以还原模型输入为目标的隐私推理攻击,攻击者可以利用其窃取人工智能模型机密和隐私数据。在拆分学习场景中服务器可以通过中间特征等信息还原客户端输入,威胁客户端的隐私安全。本文评估了拆分学习场景下的数据重构攻击风险,发现了在训练过程中客户端容易泄露自身表征偏好信息这一安全漏洞,服务器可以利用该信息伪造客户端,进而还原训练数据。与已有工作相比,该工作可以在不利用客户端隐私数据或者模型信息等先验知识的情况下比目前的SOTA攻击提升将近40%的攻击效果。同时论文还探究了该方法的可拓展性,证明了该方法可以有效结合其他领域的方案实现更强大的下游攻击任务。该工作将引起更多研究人员对拆分学习中隐私泄露问题的关注,以设计更加鲁棒且具有针对性的防御方法。

据了解,CVPR与ICCV,ECCV并列为世界三大计算机视觉会议,是计算机视觉和人工智能研究领域的顶级会议,也是中国计算机学会(CCF)推荐的A类会议。

(供图:国家网络安全学院 编辑:相茹)